.jpg)

Oamenii sînt o specie care creează unelte, dar putem controla uneltele pe care le facem? Cînd Robert Oppenheimer și alți fizicieni au dezvoltat prima armă nucleară cu fisiune în anii 1940, ei s-au temut că invenția lor ar putea distruge omenirea. Pînă acum, acest lucru nu s-a întîmplat, dar, începînd din acel moment, controlul asupra armelor nucleare a reprezentat o permanentă provocare.

În prezent, mulți oameni de știință consideră că Inteligența Artificială (IA) – algoritmi și software ce permit mașinilor să îndeplinească sarcini care necesită îndeobște inteligență umană – este un instrument la fel de revoluționar. La fel ca și alte tehnologii anterioare de largă utilizare, Inteligența Artificială are un potențial enorm – în bine și în rău. În cercetarea oncologică, ea poate tria și rezuma în cîteva minute mai multe studii decît poate face o echipă umană pe parcursul a luni de zile. De asemenea, ea poate prezice în mod fiabil modele de pliere a proteinelor, pentru a căror descoperire cercetătorii umani ar avea nevoie de ani de zile.

Dar IA reduce totodată costurile și obstacolele menite să blocheze accesul inadaptaților social, al teroriștilor și al altor actori distructivi care și-ar putea dori să facă rău. După cum a avertizat un studiu recent al RAND Corporation (Research ANd Development), „costul marginal pentru resuscitarea unui virus periculos similar variolei poate fi de doar 100.000 de dolari, în timp ce elaborarea unui vaccin complex poate costa peste un miliard de dolari”.

În plus, unii experți se tem că Inteligența Artificială avansată va fi cu mult superioară inteligenței umane, ajungînd să ne controleze ea pe noi, și nu invers. Estimările privind timpul necesar pentru dezvoltarea unor astfel de mașini superinteligente – cunoscute sub numele de „Inteligență Artificială puternică” – variază de la cîțiva ani la cîteva decenii. Oricum ar fi, riscurile tot mai mari pe care le presupune Inteligența Artificială „slabă” din ziua de azi necesită deja o atenție sporită.

Timp de 40 de ani, Aspen Strategy Group (format din foști oficiali guvernamentali, universitari, oameni de afaceri și jurnaliști) s-a reunit în fiecare vară pentru a discuta probleme majore de securitate națională. Sesiunile anterioare au abordat subiecte precum armele nucleare, atacurile cibernetice și ascensiunea Chinei. Anul acesta, ne-am concentrat atenția asupra implicațiilor IA în domeniul securității naționale, examinînd atît beneficiile, cît și riscurile.

Printre beneficii se numără o capacitate mai mare de a tria cantități enorme de informații, de a consolida sistemele de alertă anticipată, de a îmbunătăți sisteme logistice complicate și de a inspecta codul informatic pentru a îmbunătăți securitatea cibernetică. Există însă și riscuri mari, precum progresele din domeniul armelor autonome, erorile accidentale din algoritmii de programare și Inteligența Artificială adversă, care poate slăbi securitatea cibernetică.

China a făcut investiții masive în cursa înarmării pe bază de IA și se poate mîndri cu anumite avantaje structurale. Cele trei resurse-cheie pentru IA sînt datele pentru antrenarea modelelor, inginerii inteligenți pentru dezvoltarea algoritmilor și puterea de calcul necesară pentru rularea acestora. China are puține limite legale sau de confidențialitate în ceea ce privește accesul la date (deși ideologia limitează anumite seturi de date) și este bine aprovizionată cu tineri ingineri competenți. Domeniul în care China se află cel mai mult în urma SUA este cel al microcipurilor avansate care asigură puterea de calcul necesară Inteligenței Artificiale.

Controalele americane ale exporturilor limitează accesul Chinei la aceste cipuri de înaltă performanță, precum și la costisitoarele mașini litografice olandeze care le produc. Experții de la Aspen au căzut de acord că R.P. Chineză este cu un an sau doi în urma SUA – dar situația rămîne schimbătoare. Deși, la întîlnirea din toamna trecută, președinții Joe Biden și Xi Jinping au convenit să poarte discuții bilaterale privind IA, Aspen nu a manifestat un optimism excesiv cu privire la perspectivele controlului armelor pe bază de IA.

Armele autonome reprezintă o amenințare deosebit de gravă. După mai bine de un deceniu de diplomație la Organizația Națiunilor Unite, țările nu au reușit să ajungă la un acord privind interzicerea armelor letale autonome. Dreptul internațional umanitar cere ca militarii să facă distincție între combatanții înarmați și civili, iar Pentagonul cere de mult timp ca un actor uman să facă parte din ciclul decizional, înainte ca o armă să fie lansată. Dar în anumite contexte, cum ar fi apărarea împotriva rachetelor care se apropie, nu există timp pentru intervenția umană.

Deoarece contextul e important, oamenii trebuie să definească strict (în codul de programare) ce pot și ce nu pot să facă armele. Cu alte cuvinte, ar trebui să existe un om „deasupra buclei”, mai degrabă decît „în buclă” [referire la modelul de luare a deciziilor strategic-militare numit „bucla OODA” (Observă, Orientează-te, Decide și Acționează), propus de colonelul USAF John Boyd – n. trad.]. Aceasta nu este doar o chestiune speculativă. În războiul din Ucraina, rușii bruiază semnalele forțelor ucrainene, obligîndu-i pe ucraineni să își programeze dispozitivele pentru a lua decizii finale în mod autonom cu privire la momentul în care să tragă.

Unul dintre cele mai înspăimîntătoare pericole ale IA este utilizarea sa în războiul biologic sau în scopul terorismului. Atunci cînd țările au convenit să interzică armele biologice în 1972, convingerea generală a fost că astfel de dispozitive nu sînt utile, din cauza riscului de „detonare” în propria tabără. Dar, cu ajutorul biologiei sintetice, ar putea fi posibilă dezvoltarea unei arme care să distrugă selectiv un anumit grup, și nu pe altul. Iar un terorist care are la dispoziție un laborator și-ar putea dori să ucidă, pur și simplu, cît mai mulți oameni cu putință, așa cum a făcut cultul apocaliptic Aum Shinrikyo în Japonia, în 1995. (Deși a folosit sarin, care nu este transmisibil, o versiune actuală a acestui cult ar putea folosi Inteligența Artificială pentru a dezvolta un virus contagios).

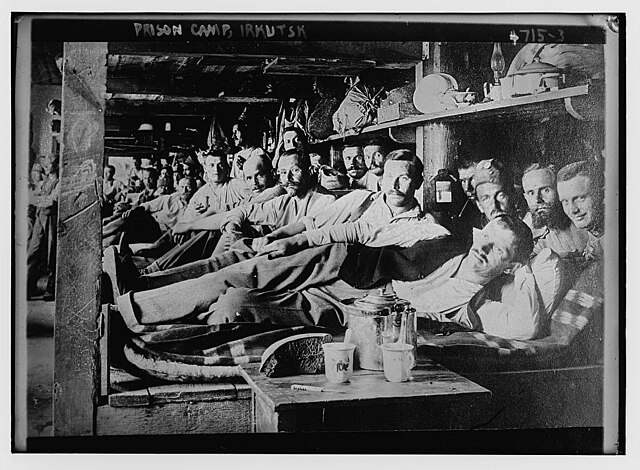

În cazul tehnologiei nucleare, țările au convenit în 1968 asupra unui tratat de neproliferare care are în prezent 191 de membri. Agenția Internațională pentru Energie Atomică inspectează periodic programele energetice naționale pentru a confirma că acestea sînt utilizate exclusiv în scopuri pașnice. Și, în ciuda rivalității intense din timpul Războiului Rece, principalele țări din domeniul tehnologiei nucleare au convenit în 1978 să aplice restricții în exportul de instalații și informații tehnice critice. Un astfel de precedent sugerează cîteva posibile perspective pentru IA, chiar dacă între cele două tehnologii există diferențe evidente.

Este un truism faptul că tehnologia avansează mai repede decît politica sau diplomația, în special atunci cînd este determinată de concurența intensă de pe piața din sectorul privat. Dacă putem vorbi de o concluzie majoră a reuniunii Aspen Strategy Group din acest an, aceasta a fost că guvernele trebuie să-și accelereze ritmul.

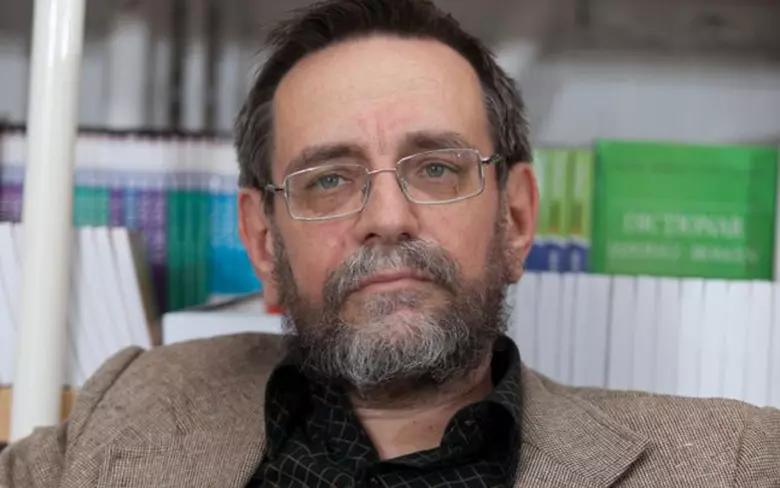

Joseph S. Nye, Jr., co-președinte al Aspen Strategy Group, este fost decan al Harvard Kennedy School, fost secretar adjunct al Apărării al SUA și autor, printre altele, al volumului A Life in the American Century (Polity Press, 2024).

Copyright: Project Syndicate, 2024

www.project-syndicate-org

traducere de Matei PLEŞU