În luna mai, anul acesta, experți din mai multe domenii s-au reunit în Muntenegru pentru a discuta despre „Amenințările existențiale și alte dezastre: Cum ar trebui să le abordăm”. Termenul „risc existențial” a fost popularizat într-un eseu din 2002 al filozofului Nick Bostrom și se referă la situații în care „un rezultat nefast fie ar anihila viața inteligentă de pe Pămînt, fie ar reduce permanent și drastic potențialul acesteia”.

Pentru a înțelege distincția dintre riscuri existențiale și alte dezastre, să luăm în considerare schimbările climatice. În unele scenarii, încălzirea globală galopantă ar putea face ca majoritatea suprafeței Pămîntului să devină prea fierbinte pentru ca oamenii să mai poată trăi în aceste regiuni, dar Antarctica și unele dintre cele mai nordice regiuni din Europa, Asia și America de Nord ar deveni locuibile.

Acest lucru ar reduce potențialul de viață inteligentă pe Pămînt, poate vreme de milenii, dar planeta s-ar răci în cele din urmă, iar descendenții supraviețuitorilor ar repopula-o. Dacă acestea sînt într-adevăr cele mai pesimiste scenarii, atunci schimbările climatice, oricît de dezastruoase ar putea fi, nu reprezintă un risc existențial.

Desigur, dacă gravitatea unui dezastru este direct proporțională cu numărul de oameni pe care îi ucide, diferența dintre un dezastru care ucide aproape întreaga populație umană a Pămîntului și unul care duce la dispariția acesteia nu ar fi atît de mare. Cu toate acestea, pentru mulți filozofi preocupați de riscul existențial, acest punct de vedere omite să ia în considerare numărul mare de oameni care s-ar naște, dacă specia noastră ar supraviețui pentru o perioadă lungă de timp, dar care nu ar exista dacă Homo sapiens ar dispărea.

Referindu-se în titlul său și la „alte dezastre”, conferința din Muntenegru nu s-a limitat doar la riscurile existențiale, chiar dacă o mare parte a discuției le-a vizat pe acestea. Spre finalul ultimei sesiuni a conferinței, unii dintre participanți au considerat că problemele pe care le-am discutat erau atît de grave – și totuși, atît de neglijate – încît ar trebui să încercăm să atragem atenția publicului și a guvernelor asupra acestui subiect printr-o declarație comună. S-a discutat apoi conținutul general al unei astfel de declarații, iar eu am făcut parte dintr-un grup restrîns desemnat să o redacteze.

Declarația menționează că există riscuri grave pentru supraviețuirea omenirii, majoritatea lor fiind create de ființele umane – fie în mod intenționat, cum ar fi bioterorismul, fie neintenționat, cum ar fi schimbările climatice sau riscul reprezentat de crearea unei super-Inteligențe Artificiale care nu este aliniată la valorile noastre. Aceste riscuri, se arată în continuare în declarație, nu sînt tratate de guverne cu seriozitatea sau urgența pe care le merită.

Declarația își susține punctul de vedere referindu-se la două afirmații făcute de Toby Ord în The Precipice, cartea sa din 2020. Ord a estimat că probabilitatea ca specia noastră să dispară în următorii 100 de ani este de 16-17%, adică o posibilitate din șase. El a estimat de asemenea că proporția din PIB-ul mondial pe care omenirea o cheltuiește pentru intervenții menite să reducă acest risc este mai mică de 0,001%.

Într-o revizuire din luna iulie, Ord afirmă că, deoarece noile dovezi sugerează că scenariile cele mai extreme privind schimbările climatice sînt puțin probabile, riscul existențial reprezentat de schimbările climatice este mai mic decît credea el că va fi în 2020. Pe de altă parte, războiul din Ucraina înseamnă că riscul ca dispariția noastră să fie provocată de un război nuclear este mai mare, în timp ce riscurile generate de Inteligența Artificială superinteligentă și de pandemii sînt, în opinia sa, mai scăzute în anumite privințe și mai ridicate în altele.

Ord consideră că accentul pus pe chatbots duce IA într-o direcție mai puțin periculoasă, deoarece chatbots nu sînt factori activi. Cu toate acestea, el consideră că o concurență crescută în cursa pentru crearea unei Inteligenței Artificiale puternice avansate [„IA puternică” sau „generală” e inteligența ipotetică a unei mașini care are capacitatea de a înțelege sau de a învăța orice sarcină intelectuală pe care o poate îndeplini o ființă umană – n. trad.] ar putea duce la o reducere a siguranței IA.

În general, Ord nu și-a schimbat estimarea – foarte aproximativă, o spune chiar el – conform căreia există o șansă din șase ca specia noastră să nu supraviețuiască în următorii 100 de ani. El salută faptul că în prezent există un interes global crescut pentru reducerea riscurilor de extincție, și oferă ca exemple includerea acestei teme în raportul din 2021 al secretarului general al Organizației Națiunilor Unite și locul important pe care aceasta îl ocupă în agenda grupului internațional de foști lideri mondiali cunoscut sub numele de „The Elders”.

Declarația din Muntenegru îndeamnă guvernele să coopereze pentru a preveni dezastrele existențiale și le cere, mai ales guvernelor țărilor bogate, să investească „resurse semnificative” în găsirea celor mai bune modalități de reducere a riscurilor de extincție a omenirii. Deși declarația nu indică ce anume înseamnă „semnificativ” în acest context, Ord a sugerat într-o altă împrejurare un angajament în valoare de 1% din PIB-ul global pentru reducerea riscurilor de dispariție a speciei noastre. Ceea ce înseamnă de o mie de ori mai mult decît estima Ord în 2020 că ar cheltui guvernele în acest scop – și totuși nu putem spune că este prea mult.

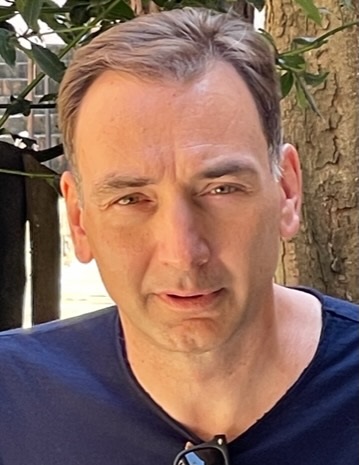

Peter Singer, fondator al organizației The Life You Can Save, e profesor emerit de Bioetică la Universitatea Princeton. Este, împreună cu Kasia de Lazari-Radek, gazda podcast-ului Lives Well Lived. Și e autorul cărților Animal Liberation, Practical Ethics, The Life You Can Save, The Most Good You Can Do și coautor (împreună cu Shih Chao-Hwei) al cărții The Buddhist and the Ethicist (Shambhala Publications, 2023).

Copyright: Project Syndicate, 2024

www.project-syndicate-org

traducere de Matei PLEŞU

.jpg)

.jpg)

.jpg)