Zilele trecute, unul dintre noi (Anca) a primit un e-mail în două paragrafe: o întrebare și prezentarea succintă a situației. După semnătură mai existau trei rînduri de asigurare că e-mail-ul este scris respectuos și că are tot ce trebuie pentru a primi un răspuns de la profesor.

„Eram total de acord cu aceste rînduri. Adică de acord, probabil, cu robotul care a ajutat în redactarea e-mail-ului. Sigur că am răspuns. Dar m-am și întrebat care e motivația unui student de a folosi o aplicație ca să se asigure că a formulat un e-mail suficient de bine cît să primească un răspuns. Sînt aceste aplicații folosite pentru că studenții nu știu cum să redacteze un e-mail sau se tem să nu greșească, sau fac mai amuzantă o activitate care ar putea să fie plictisitoare, implicîndu-se în «discuții» cu un chatbot? Sau le folosesc doar pentru că și alții o fac?”

De 150 de ani, sociologia a dezvoltat metode prin care caută să exploreze, să descrie, să prezică sau să explice acțiuni, comportamente sau perspectivele diferitelor grupuri sociale și interacțiunile dintre ele. Pe lîngă colectarea și analizarea de date, utilizează și dezvoltă teorii sociologice pentru a-și susține interpretările. Ceea ce e mai complicat poate în sociologie decît în alte științe este că se ocupă cu decodarea unor simboluri și realități sociale convenite de-a lungul timpului de oameni, deci, mai degrabă, subiective. Subiective în sensul că sînt create și modificate permanent de indivizi și de interacțiunile dintre ei. Poate tocmai de aceea cercetătorii (și nu numai) urmăresc nu doar rezultatele cercetărilor, ci și contextul în care au fost ele produse.

De bază pentru cunoașterea sociologică e că oamenii au atitudini diferite în funcție de cum se situează față de ceilalți, adică de experiențele anterioare, de educație, de accesul la informații și alte resurse, de interese și oportunități printre altele. Potrivit teoremei lui Thomas, modul în care indivizii înțeleg o realitate este mai important decît realitatea în sine, pentru că vor acționa pornind de la interpretarea respectivei realități.

Digitalizarea a influențat și modalitățile în care se lucrează în sociologie și, pe lîngă utilizarea instrumentelor digitale, sociologii își pun probleme despre consecințele utilizării lor. În prezent, de exemplu, ne întrebăm cum (și dacă) modelele lingvistice mari, cum sînt ChatGPT, Copilot sau Gemini, printre altele, ne ajută în învățarea sociologiei. Sau generarea de texte, folosind aceste programe, mai mult încurcă, încurajînd comoditatea sau chiar stimulînd frauda academică? Aceste aplicații au generat controverse și în educație. De exemplu, unele universități se opun utilizării, în timp ce altele încurajează folosirea lor în procesul didactic. Discuțiile publice despre consecințele acestor aplicații variază de la încredere că vor crea mai multă prosperitate la teamă pentru viitorul umanității.

Adevărul în era digitală

Pentru aflarea adevărului în era digitală e nevoie de responsabilitate individuală, pe de-o parte, și de crearea unor mecanisme de protejare și verificare, pe de alta.

În ceea ce privește responsabilitatea individuală, o analogie bună se poate face cu medicina. Cartea Cu ultima suflare evidențiază responsabilitatea medicului pentru pacienții pe care îi tratează și cum este aceasta percepută în timpul studiilor și în practica profesională, construindu-se și reconstruindu-se de-a lungul carierei. De cealaltă parte există medicii (sau pretinși medici) care dau sfaturi folosind rețelele de socializare.

Reglementările în vigoare din domeniul sănătății protejează pacienții și responsabilizează personalul medical, în timp ce lipsa de reglementări în mediul online transferă integral responsabilitatea asupra indivizilor care se informează din sursele pe care le consideră potrivite. În definitiv, cine e responsabil dacă o persoană se îmbolnăvește pentru că a urmat recomandările de nutriție ale unui influencer care are cunoștințe medicale? Se poate ca informația distribuită să nu fi fost greșită, ci doar să nu se potrivească situației persoanei care o adoptă.

Și mai este, desigur, și problematica știrilor false. Din perspectiva responsabilității individuale, nu doar că e dezirabil să nu fim parte a celor care creează informație falsă, dar avem și responsabilitatea să distribuim conținut pe care îl verificăm. Rețelele de socializare facilitează accesul la știri false și distribuirea lor. Folosite împreună cu modele lingvistice mari, știrile false pot fi mai ușor create. Pentru abordarea problemelor cauzate de știrile false este nevoie de eforturi multidisciplinare (vezi The science of fake news).

Utilizarea modelelor lingvistice mari e de dată recentă, ChatGPT-ul fiind lansat de aproximativ doi ani. Între timp, nu doar că sînt dezvoltate și alte aplicații, dar au și fost publicate rezultatele unor cercetări despre experiențele în utilizarea Inteligenței Artificiale (AI). Unul dintre materialele pe care le-am citit despre acest subiect a fost identificat întrebînd în aplicația Copilot, în limba engleză, dacă există sondaje și studii la nivelul Uniunii Europene care investighează utilizarea AI-ului în universități. Fără a intra în detalii despre rezultatele prezentate în studiul de caz, despre cum studenții la ETH Zürich folosesc AI, descriem cum am ajuns la el.

Copilot este o aplicație la care avem acces printr-un cont instituțional. După scrierea întrebării în căsuța de text și apăsarea butonului de trimitere a mesajului, aplicația formulează un răspuns prietenos, structurat de obicei, în care sînt menționate și sursele pentru fiecare punct – pare o versiune interactivă a utilizării unui motor de căutare. În această situație am primit un răspuns în limba engleză care începe cu: „Da, există mai multe sondaje și studii la nivelul Uniunii Europene care investighează utilizarea AI în universități. Aici sînt cîteva exemple” – și urmează o listă de trei studii. După fiecare studiu este o notă de final care duce către un buton cu legătură către pagina web unde se află materialele identificate. După lista celor trei este un rezumat al acelor studii: „Aceste studii includ de obicei întrebări despre…” – și urmează o listă cu patru marcatori. Se încheie cu „Vrei să afli mai multe despre rezultatele acestor sondaje sau întrebările specifice pe care le-au întrebat? Află mai multe” – și urmează lista de link-uri pentru studiile găsite.

Sub text există butoane pentru a indica dacă îți place sau nu răspunsul și pentru a-l copia, precum și un mesaj de avertizare: „Textul generat de AI ar putea fi incorect”. Sub acestea sînt trei întrebări recomandate. Dacă apăsăm pe una din ele, sîntem trimiși la o nouă întrebare, generînd un nou răspuns. În motorul de căutare folosit (Edge) există posibilitatea generării traducerii introduse mai sus automat, cu ajutorul AI. Tot ce trebuie făcut e selectarea textului, apăsarea click dreapta și apoi alegerea opțiunii de traducere în română. Nu am procedat astfel, pentru că dura mai mult generarea traducerii decît să traducem singuri.

În discuții informale cu colegi cadre didactice, explorăm dacă e etic să fie folosite aceste aplicații și, cînd/dacă agreăm că nu se poate să interzicem folosirea lor, pentru că studenții vor găsi o cale să le folosească, limitele în care am putea permite utilizarea lor. Dacă permitem utilizarea, trebuie să avem în vedere că aspecte precum tipul dispozitivului utilizat, nivelul abilităților digitale sau disponibilitatea de a folosi asemenea instrumente ar putea crea noi inegalități. Pe de altă parte, dacă nu permitem, s-ar putea ca, în timp, să observăm că absolvenții au mai puține abilități comparativ cu alții din alte programe universitare similare, unde aceste aplicații au fost introduse în procesul de învățare într-o manieră controlată și intenționată.

Se discută și despre accesul companiilor care dețin modele lingvistice mari la toate materialele folosite pentru a dezvolta învățarea acestor roboți, dacă au avut sau nu acordul autorilor.

Tot din discuții informale, dar cu studenții, reiese că aceștia folosesc aplicații pentru documentare sau pentru reformularea textelor scrise de ei. Similar cu rezultatele studiului de caz găsit cînd am folosit Copilot. Printre altele, studenții care au răspuns la sondaj menționează nevoia de a verifica informația generată de AI și par conștienți că a copia textul și a și-l asuma ca fiind autorii lui este fraudă. Dar apar întrebări: chiar verifică de fiecare dată dacă rezultatele generate de AI sînt corecte? Și dacă da, cum și unde verifică informația? Nu copiază nici măcar un fragment? Și dacă doar citesc textul generat de AI, fără să verifice sau să-l folosească într-un alt fel, ce se întîmplă cu informația citită? Dacă se reține neintenționat, va fi corectată în timp, dacă a fost informație greșită sau fictivă?

Responsabilitatea utilizării modelelor lingvistice mari

Aceasta duce la una dintre marile probleme cu utilizarea modelelor lingvistice mari în mediul academic și în știință: cum facem să ne asigurăm că se utilizează în mod responsabil?

Sînt și studenți care nu au folosit asemenea instrumente și nu doresc să o facă. S-ar putea să le folosim, fără să știm, pentru că unele aplicații au integrat deja AI-ul. Un exemplu ușor de observat este atunci cînd scriem e-mail-uri, dacă, după finalizarea scrierii unui cuvînt, ne sînt recomandate „cuvintele următoare”.

Microsoft Edge este un browser care are mai multe elemente de Inteligență Artificială introduse care permit, printre altele, realizarea de traduceri de text din pdf-uri deschise în acest browser, ascultarea textului scris sau chiar realizat un rezumat al textului cu ajutorul Copilot.

În timp ce adevărul factual ar putea fi stabilit, interpretarea acestuia poate varia în funcție de grupul din care individul face parte. Pe lîngă nivelul de educație, genul sau contextul socio-economic care influențează percepțiile asupra realităților sociale supuse cercetării, mai există și limite ale gîndirii (Gîndire rapidă, gîndire lentă, de Daniel Kahneman, prezintă și altele). De exemplu, tendința oamenilor de a reține informații familiare (The Role of Familiarity in Correcting Inaccurate Information) sau care le fac plăcere și de a se documenta mai degrabă atunci cînd informația aflată contravine părerilor lor.

Să fim curioși, să avem îndoieli, să ne propunem să înțelegem, să ne informăm din surse de încredere și să reluăm studii empirice învățînd din greșeli sînt cîteva din lucrurile pe care le putem face pentru a ne apropia mai mult de ceea ce este adevărat.

Zonele mai puțin glamour

Dincolo de practica pedagogică, ştiinţele sociale mai pot contribui cu ceva la discuţia despre AI. Unul din lucrurile pe care ştiinţele sociale le fac bine este creşterea vizibilităţii zonelor mai puţin glamour ale salturilor tehnologice, precum şi interogarea elanului profetic al tehnologiei. Mulţi percep că AI este un creier pur care funcţionează independent de procese materiale de producţie şi de formă de muncă repetitivă. „Managerii din Silicon Valley ar dori ca noi să vedem AI ca fiind o magie, că e doar o mașină de creație care ne face visele să devină realitate, care poate să genereze supraomul, care permite noi frontiere ale creativității. Perspectiva mai potrivită e de a vedea AI ca pe o mașină de extracție”, notează un studiu.

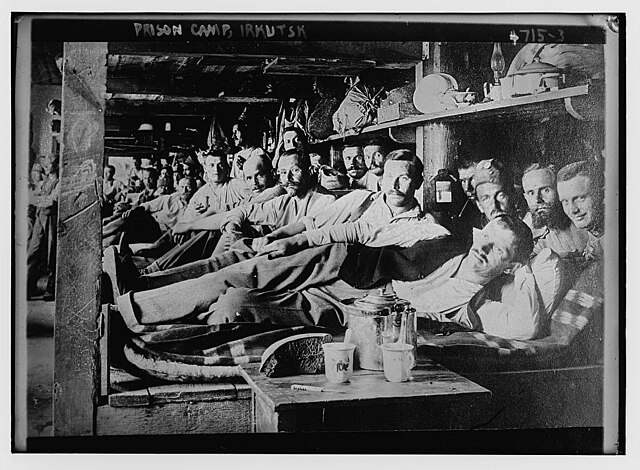

Există însă o istorie îndelungată de profeţii tehnologice neîmplinite, de past futures, cum le numeşte istoricul Reinhert Koselleck. De exemplu, în valul anterior de automatizări din anii ’50-’70, inclusiv din locuințe, exista temerea că oamenii vor munci în anii ’80 doar 15 ore pe săptămînă, însă statisticile arată că volumul de muncă a crescut substanţial. Automatizarea s-a extins în angajări şi concedieri, supraveghere, deschiderea automată a focului pe baza recunoaşterii faciale, testarea tehnologiei militare smart pe populaţii vulnerabile, în munca precară în capitalismul de platformă, accesul în apartamente şi în spaţii private şi administrarea serviciilor sociale la populaţii cu deficit de cunoştinţe digitale de netrecut (excluse, practic, prin lipsa de acces tehnologic).

Toate acestea sînt lucruri care necesită însă înţelegere contextuală şi filtre etice. Lucrînd cu date vaste (big data), „riscul este să simplifice sau să ignore exact variaţiile subtile care există între noi”. De exemplu, proptech – tehnologia smart de administrare a accesului în apartamentele oferite la închiriere de agenţii imobiliari cu portofoliu de sute sau mii de unităţi locative din oraşe precum San Francisco sau New York – dă rateuri la recunoaşterea facială a chiriaşilor cu pielea mai închisă, pentru că a fost dezvoltată pe prelucrarea imaginilor digitale ale albilor.

Costurile pe care le implică Inteligența Artificială

Pe de altă parte, latura materială a AI-ului nu este lipsită costuri ascunse. AI consumă foarte mult curent electric şi apă pentru răcirea serverelor (cam 5% din consumul total de apă din SUA este folosit pentru răcirea serverelor) sau foloseşte muncă manuală sau creativitate umană care ne apar, din exterior, drept muncă automatizată.

AI este vulnerabil la schimbările climatice. Uraganul Helen care a devastat părţi însemnate din statul Carolina de Nord, „inclusiv un oraş denumit Spruce Pine de unde se obține nisip de cuarț de înaltă puritate, care e folosit pentru a face cipuri semiconductoare. Această descriere a lucrurilor drept cloud maschează toate aceste moduri în care (AI) este construit pe un sistem foarte-foarte fizic, care necesită multă energie, multă apă, precum și multă muncă umană”.

Potrivit unui studiu, „noile centre de date construite în Marea Britanie în următorii cinci ani ar putea avea nevoie de aceeași cantitate de apă ca 500.000 de oameni. Sectorul este îngrijorat de faptul că multe dintre noile facilități vor fi grupate în sud-estul Angliei, care este mai uscat decît Istanbul și Dallas”.

Scrierea unui e-mail de 100 de cuvinte cu ajutorul ChatgGPT consumă o jumătate de litru de apă.

Ce părere au profesorii

După cum puteți vedea mai jos, există o diversitate de integrare a AI în practica de cercetare și pedagogică. Uneori relatările la prima mînă redau mai bine această diversitate, așadar redăm mai jos cîteva lucruri relatate de colegele și colegii noștri.

# Marian Vasile, conferențiar, Facultatea de Sociologie și Asistență Socială, Universitatea din București: „ChatGPT este un instrument pentru oameni informați. Este ca într-o relație, dacă te aștepți să facă el/ea totul, atunci nu o să meargă. Trebuie să investești și tu, utilizatorul, timp în profesia ta ca să aveți o relație funcțională. ChatGPT spune multe prostii, e un lover boy sau o lover girl, de aceea îți trebuie capacitatea de a discerne ce e corect de ceea ce inventează sau vorbește pe lîngă (bullshit). În învățămîntul superior apare și o terță parte, profesorul, care, oricît ar bate daraua negaționismului, are un rol critic de a cerne informația monumentală care circulă azi înainte să o prezinte și să o discute cu studenții și studentele. Un profesor implicat, care citește la literă temele și își cunoaște studenții și studentele, are șanse foarte mari să își dea seama dacă «vorbește» cu cine trebuie sau are în față o lucrare AI. Am urmărit ce fac alții în străinătate la universități de prestigiu, iar tendința, cel puțin în științele sociale, pare să fie evaluarea continuă prin interactivitate în sală, evaluarea pornind de la rezolvarea unor scenarii din viața reală, nu pe reproducerea conținuturilor predate, evaluarea în sală sub constrîngere de timp”.

● Daniela Niță, lector, Facultatea de Sociologie și Asistență Socială, Universitatea din București: „Sînt de părere că tehnologiile AI trebuie integrate cît mai rapid și cît mai armonios posibil în procesul educațional. Să le cerem studenților care sînt nativi digitali să nu folosească tehnologiile AI în procesul educațional este ca și cum s-ar fi cerut generațiilor anterioare să nu se uite la televizor sau să nu folosească Internetul pentru informare. Ideea care trebuie subliniată cu fiecare ocazie este că rigorile citării academice rămîn în vigoare chiar și cu ChatGPT la îndemînă. (...) Mult mai eficient pe termen lung mi s-ar părea însă să permitem studenților să folosească ChatGPT și alte instrumente asemănătoare cu condiția să fie transparenți cu privire la asta (să menționeze explicit ce întrebări au adresat în ChatGPT și cum au procesat ei înșiși informația pentru a o include în proiecte/lucrări) – în felul acesta se pot face pași concreți pe direcția consumului responsabil de resurse AI”.

● George Bonea, georgeisme.ro, doctorand, Facultatea de Sociologie și Asistență Socială, Universitatea din București: „Pînă în prezent am sesizat că foarte puțini studenți folosesc ChatGPT în sensul în care să dea copy-paste din răspunsurile pe care le primesc de la el. Sub 5%. Dacă lucrezi des cu AI-uri de tipul ChatGPT îți poți da seama destul de repede dacă răspunsurile vin de la studenți care abia învață diverse concepte, exotice pînă atunci pentru ei, ori de la un AI care le știe pe toate și are limbajul la el. Altfel, am încurajat studenții să folosească diverse forme de AI pentru calitatea acestora de a agrega informații, faptul că are tendința să stereotipizeze (lucrează cu șabloane și poți afla lucruri interesante despre percepția soft-ului vizavi de diverse categorii sociale), pentru a vedea de ce este capabil și pentru a încerca să gîndească altfel decît o face un soft a cărui singura calitate este că amestecă (impresionant) și ordonează un volum uriaș de informații. Plus că o artă este și să știi ce să îi ceri AI-ului, ce să îi promptezi”.

● Raluca Creangă, Cercetătoare în Antropologie Digitală/User Experience, Lector Asociat la Facultatea de Sociologie și Asistență Socială (Universitatea București): „Asistenții conversaționali dotați cu inteligență artificială, de tip ChatGPT, Code Lama sau Web-Search, au stîrnit curiozitatea din momentul lansării lor și au determinat oamenii să testeze aceste programe pentru a descoperi ce sînt și mai ales cum pot să le folosească. Companiile care le-au creat și implementat le promovează ca suplimentînd funcțiile motoarelor de căutare și totodată ca ajutoare în diverse activități, mai ales legate de muncă/învățare. În acest context, mulți oameni au început individual să folosească asistenții pentru a edita texte (e-mailuri, prezentări, lucrări școlare/academice), pentru a programa (a edita limbaje de programare sau crea de la zero), pentru a genera imagini (folosind funcții speciale care pot să fie folosite) și așa mai departe. Popularitatea programelor pentru aceste acțiuni specifice, precum și creșterea adopției a determinat companiile să dezvolte programe proprii, sub brand propriu. Motivația principală de a se duce în această direcție și de a nu folosi programele existente este nuanțată, dar că ține de a demonstra intern (mai ales pentru stakeholderi) și extern (clienți, companii partenere etc) abilitățile de a răspunde rapid la tendințele globale. Adesea aceste companii își transformă angajații, cît și clienții, în contribuitori responsabili de expandarea și rafinarea capacităților acestor programe; utilizarea internă a acestor programe fiind inclusă uneori în evaluarea periodică a angajaților. Consider această abordare ca fiind problematică, mai ales din prisma lipsei de transparență - companiile au sărit să implementeze aceste programe sau le-au adoptat la nivel global, nedefinind exact cum, cînd și unde trebuie folosite aceste programe, care sînt limitele utilizării lor de către angajați și mai ales care sînt riscurile utilizării lor pe termen mediu și lung. E cu siguranță o nouă frontieră, pe care trebuie să ne oferim puțin răgaz să o observăm înainte de acționa.”

Anca Mihai este lector univ. dr., Facultatea de Sociologie și Asistență Socială, Universitatea din București.

Liviu Chelcea este profesor dr., Facultatea de Sociologie și Asistență Socială, Universitatea din București.

.jpg)

.jpg)

.jpg)